HBase简介

Hadoop Database,是一个高可靠性、高性能、面向列、可伸缩、 实时读写的分布式数据库

利用Hadoop HDFS作为其文件存储系统,利用Hadoop MapReduce来处理 HBase中的海量数据,利用Zookeeper作为其分布式协同服务

主要用来存储非结构化和半结构化的松散数据(列存NoSQL数据库)

Hbase和DBMS比较

查询数据不灵活:

1、 不能使用column之间过滤查询

2、 不支持全文索引。使用solr和hbase整合完成全文搜索。

a) 使用MR批量读取hbase中的数据,在solr里面建立索引(no store)之保存rowkey的值。

b) 根据关键词从索引中搜索到rowkey(分页)

c) 根据rowkey从hbase查询所有数据

HBase数据模型

ROW KEY

决定一行数据

按照数据字典排序

Row Key只能存储64K的字节数据

Column Family列族 & qualifier列

HBase表中的每个列都归属于某个列族,列族必须作为表模式(schema) 定义的一部分预先给出。如create ‘test’, ‘course’;

列名以列族作为前缀,每个“列族”都可以有多个列成员(column);如 course:math, course:english, 新的列族成员(列)可以随后按需、动态加入;

权限控制、存储以及调优都是在列族层面进行的;

HBase把同一列族里面的数据存储在同一目录下,由几个文件保存。

Timestamp时间戳

在HBase每个cell存储单元对同一份数据有多个版本,根据唯一的时间 戳来区分每个版本之间的差异,

不同版本的数据按照时间倒序排序, 最新的数据版本排在最前面。

时间戳的类型是64位整型。

时间戳可以由HBase(在数据写入时自动)赋值,此时时间戳是精确到毫 秒的当前系统时间。

时间戳也可以由客户显式赋值,如果应用程序要避免数据版本冲突, 就必须自己生成具有唯一性的时间戳。

Cell单元格

由行和列的坐标交叉决定;

单元格是有版本的;

单元格的内容是未解析的字节数组;

由{row key,column(=<family> +<qualifier>),version}唯一确定的单元。

cell中的数据是没有类型的,全部是字节码形式存贮。

HLog(WAL log) (既存操作也存数据)

HLog文件就是一个普通的Hadoop Sequence File,

Sequence File 的Key是 HLogKey对象,HLogKey中记录了写入数据的归属信息,

除了table和 region名字外,同时还包括sequence number和timestamp,

timestamp是” 写入时间”,sequence number的起始值为0,或者是最近一次存入文件系 统中sequence number。

HLog SequeceFile的Value是HBase的KeyValue对象,即对应HFile中的 KeyValue

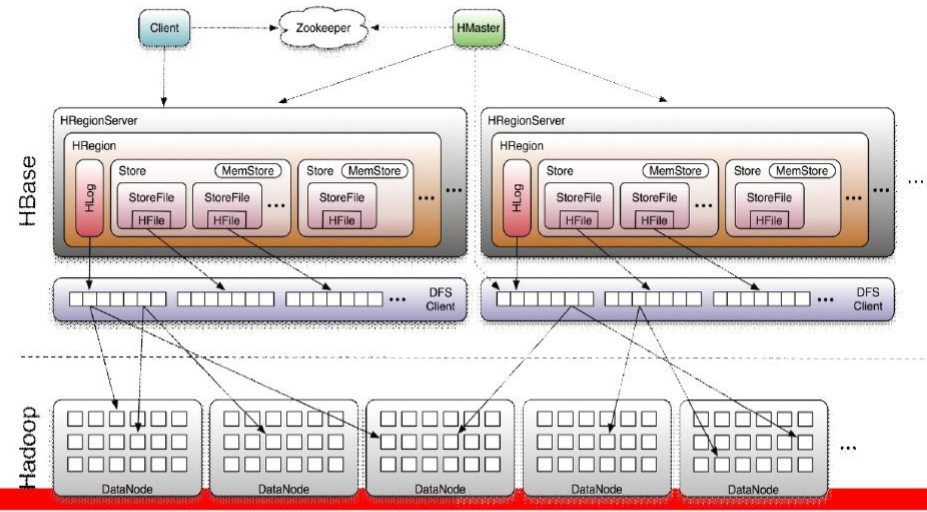

HBase体系架构

Client

包含访问HBase的接口并维护cache来加快对HBase的访问

Zookeeper

保证任何时候,集群中只有一个master

存贮所有Region的寻址入口。

实时监控Region server的上线和下线信息。并实时通知Master

存储HBase的schema和table元数据

Master

为Region server分配region

负责Region server的负载均衡

发现失效的Region server并重新分配其上的region

管理用户对table的增删改操作

RegionServer

Region server维护region,处理对这些region的IO请求

Region server负责切分在运行过程中变得过大的region

Hbase存储模型

Region

HBase自动把表水平划分成多个区域(region),每个region会保存一个表里面某段连续的数据;

每个表一开始只有一个region,随着数据不断插入表,region不断增大,当增大到一个阀值的时候,region就会等分为两个新的region(裂变);

当table中的行不断增多,就会有越来越多的region。然后就会转移保存在多个Regionserver上。

Memstore 与 storefile

一个region由多个store组成,一个store对应一个CF(列族)

store包括位于内存中的memstore和位于磁盘的storefile写操作先写入memstore,

当memstore中的数据达到某个阈值,hregionserver会启动 flashcache进程写入storefile,每次写入形成单独的一个storefile

当storefile文件的数量增长到一定阈值后,系统会进行合并(minor、 major compaction),

在合并过程中会进行版本合并和删除工作 (majar),形成更大的storefile

当一个region所有storefile的大小和数量超过一定阈值后,会把当前的region分割为两个,并由hmaster分配到相应的regionserver服务器,实现负载均衡

客户端检索数据,先在memstore找,找不到再找storefile

Region是HBase中分布式存储和负载均衡的最小单元。最小单元就表示不同的HRegion可以分布在不同的HRegion server上。

Region由一个或者多个Store组成,每个store保存一个columns family。

每个Strore又由一个memStore和0至多个StoreFile组成。

伪分布式部署

tar xf hbase-0.98.12.1-hadoop2-bin.tar.gz -C /usr/local/

vi hbase-env.sh

export JAVA_HOME

vi hbase-site.xml<configuration>

<property>

<name>hbase.rootdir</name>

<value>file:///home/hbaseuser/hbase</value>

</property>

<property>/

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/hbaseuser/zookeeper</value>

</property>

</configuration>完全分布式部署

Master ZK RegionServer

node1 1 1

node2 1 1

node3 1 1

node4 1

node5 1

1、免密钥、时间同步

node1 - -> 1~5

node5 - ->1~5

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

yum install ntp -y

ntpdate 202.120.2.1012、 配置文件 (/hase/conf)

hbase-env.sh

#java-home

export JAVA_HOME=/usr/java/jdk1.7.0_67

#zk-manager:false

export HBASE_MANAGES_ZK=false

hbase-site.xml

<property>

<name>hbase.zookeeper.quorum</name>

<value>node01,node02,node03</value>

</property>

<!-- 注意 如果添加zk datadir配置 需要和 zk集群中的保持一致 不配也可以 -->

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/opt/zookeeper</value>

</property>

<property>

<name>hbase.rootdir</name>

<value>hdfs://nn-cluster/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property> regionservers

node02

node03

node04作为备份的master节点

backup-masters

node05hdfs-site.xml需要拷贝到hbase的conf目录中

3、同步配置文件

4、启动hdfs集群

5、node01上 start-hbase.sh 启动hbase集群

6、hbase shell启动控制台

!如果hbase搭建过程当中出现问题 通过zkCli.sh 连接zk集群 查看/hbase节点是否存在

如果存在 重新启动hbase之前 先删除该节点 rmr /hbase